Notizprogramme

Mit Beginn des Referendariats musste ich anfangen, Unterrichtspläne zu erstellen. Dafür gibt es je nach Seminarlehrer (das sind die, die einem das Unterrichten beibringen) unterschiedliche Vorlagen bzw. Vorstellungen, im Wesentlichen legt man aber eine Tabelle an, in der ganz links die Zeit steht, daneben meist die Sozialform und/oder die verwendeten Medien und rechts dann der zu unterrichtende Inhalt in unterschiedlicher Detailliertheit. Die ersten Schritte dazu habe ich in Word gemacht und die damit erstellten Pläne dann ausgedruckt bzw. händisch – mit zusätzlichen Kommentaren und Hinweisen für mich, die in der Stunde wichtig sein könnten – auf A5-Blätter übertragen, die ich dann im Unterricht in der Hand oder vor mir auf dem Tisch liegen hatte.

Gegen Ende des Schuljahres an der Einsatzschule, wo ich komplett allein und eigenverantwortlich unterrichten konnte, durfte und musste, zog dann ein iPad Mini bei uns ein, welches die handgeschriebenen A5-Bögen ersetzt hat. Es ist halt irgendwie praktischer, seine Notizen und Planungen aller Stunden immer griffbereit in der Hand zu haben, vor allem wenn man sie dann auch noch spontan abändern kann (und die Änderungen nicht am Nachmittag daheim vom A5-Papier auf die Datei im Computer übertragen muss).

Rückblickend ist das alles ganz schön lange her… eine Zeit, in der der Begriff Cloud noch nicht so ganz klar und meist synonym mit Dropbox war, in der es in jedem Klassenzimmer (nur) einen Overhead-Projektor gab und man sich einen der 3-4 Beamer, die es in der ganzen Schule gab, nach vorheriger Reservierung in irgendeinem Medienkammerl oder einem Regal im Lehrerzimmer ausleihen musste, um ihn dann ins Klassenzimmer zu tragen und erst mal aufwändig zu verkabeln und in der die sogenannte Medienwagen (alter Fernseher, DVD-Player, Videorecorder) Standard waren, wenn man einer Klasse einen Film zeigen wollte.

Mit dem Wechsel auf das iPad stand dann auch ein Wechsel der Software an: Word war damals auf dem iPad ein wenig unbeholfen, zudem hätte man dann die Dateien immer vom heimischen PC aufs iPad und wieder zurück kopieren müssen, was doch sehr umständlich gewesen wäre. Eine geeignete Alternative war damals Evernote, eine Cloud-basierte Notizsoftware, in der man seine Notizen in durch Schlagworte (Tags) geordneter Form sortieren und filtern konnte. Zwar waren die Formatierungsmöglichkeiten im Vergleich zu Word deutlich eingeschränkt, aber eine Tabelle anlegen und Text rudimentär mit Fettdruck, Kursivierung etc. gestalten konnte man schon. Außerdem konnte man, wenn ich mich richtig erinnere, auch Bilder und Dateien als Anhang einfügen, sodass man z. B. zur Stunde gehörige Medien gleich „bei der Hand“ hatte, um sie dann – wir reden von 2013 – auszudrucken und auf Folie zu kopieren (bitte nur in schwarz-weiß, Farbe wäre zu teuer, und heben Sie die Folie bitte nach der Stunde fürs nächste oder übernächste Schuljahr auf). Mit Evernote bin ich dann auch gut durch den Rest des Referendariats und ins „richtige“ Berufsleben gekommen, wobei die angehängten Medien dann mit dem Wechsel ans damals frisch eröffnete und daher besonders gut ausgestattete Gymnasium Trudering PowerPoint-Präsentationen gewichen sind bzw. um diese ergänzt wurden. Da es in Trudering, man höre und staune, in jedem Zimmer einen (fest installierten) Laptop für die Lehrer sowie ein interaktives Whiteboard mit Beamer und Lautsprechern gab, konnte man einfach alles, was man in der Stunde so vorhatte, in die PPT schmeißen und dann im Laufe des Unterrichts abspulen. Sehr schick.

Im Laufe der Zeit begann ich allerdings, mit Powerpoint zu hadern, da es mir im Unterrichtsalltag etwas unflexibel erschien. Hefteinträge zum Abschreiben (digitale Geräte hatten nur die Lehrer, erst mal nicht die Schüler) sind ja schön und gut, wenn man aber etwas spontan ändern oder ergänzen wollte, war PowerPoint doch eher unflexibel. Präsentationsmodus beenden, richtige Folie suchen, Änderungen vornehmen, Präsentation wieder starten – nicht richtig schnell. Das damals für die Whiteboards zur Verfügung stehende „Easiteach“ war noch viel schlimmer, weil noch unflexibler, langsamer und durch ein schreckliches User-Interface gehandicapt.

Da mein iPad mittlerweile von einem Microsoft Surface mit Stylus (also digitalem Stift) abgelöst worden war, stand mir eine andere Möglichkeit offen: Warum nicht einfach die wichtigsten Anweisungen vorab tippen und spontane Sachen mit dem Stift handschriftlich, aber eben digital und damit für später gesichert, notieren? Das geht und ging auch in PowerPoint über die Freihandfunktion, war aber nie wirklich schön (und sah spätestens, wenn man die Folie im nächsten Jahr wieder verwenden wollte, schrecklich aus).

Also probierte ich Microsofts OneNote als Alternative aus. Das ist im Grunde eine reine Notiz-Software, so wie Evernote, zu dem Zweck entwickelt, eigene Gedanken oder Mitschriften zu erstellen und zu ordnen. Zu diesem Zweck kann man in OneNote nicht nur getippte Notizen erstellen (und diese in Form von Notizbüchern mit verschiedenen Abschnitten und Abschnittsgruppen sortieren), sondern auch praktisch alle Medien und Dateien, die es gibt, als Anhänge bzw. direkt sichtbar in die Notizen einfügen. Bilder werden also direkt in OneNote angezeigt, Audiodateien lassen sich sofort aus dem Programm heraus abspielen und Dokumente oder andere Dateien werden als Anhang eingefügt und dann mit Hilfe anderer Software geöffnet. Zudem synchronisiert OneNote, wenn man das möchte, mit Microsofts Cloud OneDrive, sodass man mehrere Geräte parallel nutzen kann (z. B. den PC zu Hause, den Laptop in der Schule oder das iPad für unterwegs) und außerdem auch noch über das Web auf seine Notizen zugreifen kann.

Neben dem getippten Text ist OneNote außerdem auch für handschriftliche Notizen mit dem Stylus optimiert, was insbesondere mit dem MS Surface zusammen gut harmonierte. Hier kam und kommt ein gut lesbares, ordentliches Schriftbild heraus. Da man bei OneNote eine unendlich große Leinwand für jede Notiz hat, habe ich es als Präsentationssoftware entfremdet und meine Arbeitsaufträge usw. für die Schüler links getippt und spontane Ergänzungen, „Tafel-„Anschriebe usw. einfach ein Stück weiter rechts daneben handschriftlich notiert.

So bin ich die letzten rund 10 Jahr gut gefahren, auch ein Wechsel vom Surface auf ein iPad und dann ergänzend das MacBook war kein Problem: OneNote gibt es auch für iPadOS (und iOS) sowie MacOS. Ich konnte also einfach das Programm installieren, meldete mich bei OneDrive an und konnte nach kurzer Synchronisation loslegen. Brilliant. Und alle Texte, Medien, Arbeitsblätter usw. waren als Dateien direkt in OneNote bei meinen Unterrichtsplanungen abgelegt, sodass man nicht erst am PC in irgendwelchen Ordnern danach suchen musste.

Also alles gut? Naja, fast. Da im Laufe der Zeit doch eine ganz schöne Menge an Material zusammengekommen ist, brauchte ich natürlich entsprechend viel Platz in der Cloud. Außerdem wollte ich auch die zugehörigen Programme des Office-Pakets nutzen und habe daher seit Jahren immer schon das jährliche Abo für Mircosoft 365 (vorher Office 365) gezahlt. Kriegt man, wenn man auf Angebote achtet, für ca. 50-60 Euro im Jahr und lässt sich natürlich auch steuerlich absetzen, aber ist auch Geld.

Zudem kommt im schulischen Bereich ein großes Problem hinzu: Der Datenschutz. Da die Daten bei Microsoft auf amerikanischen Servern lagen und liegen, durften hier keine personenbezogenen Daten von Schülern rein. Zwar biete Microsoft irgendwelche Pakete mit EU-Servern an, aber wie und ob die eigenen Daten auch wirklich dort und nur dort liegen, war in meinen Augen immer etwas nebulös… verlassen wollte ich mich jedenfalls nicht darauf.

Außerdem löst Microsoft bei mir noch immer nicht unbedingt die besten Gefühle aus, was sicher noch aus Zeiten der Monopol-Prozesse um Internet Explorer usw. stammt, und irgendwie hätte ich meine Daten doch gern mehr unter meiner Kontrolle gehabt.

Ausschlaggebend war dann der (zweite) Wahlsieg von Donald Trump 2024, der zur Folge hatte, dass dieser nach seiner Inauguration mit einem wahren Wirbel an Dekreten viel Vertrauen in US Firmen zerstört hat, vor allem, da sich diverse Unternehmen (allen voran Meta, X und OpenAI) ihm regelrecht zu Füßen geworfen haben. Hier wurde mein Vertrauen in die bisher bestehenden, ohnehin reichlich wackligen, rechtlichen Vereinbarungen zum Schutz der Daten europäischer Bürger massiv erschüttert und ich begann mich nach einer Alternative zu OneNote und der Microsoft-Cloud umzusehen.

Die Alternativen: Es gibt ja einen riesigen Markt voller Notiz-Programme, die jedes für sich verschiedene Vor- und Nachteile haben. Ich habe wirklich viele probiert, und so richtig 1:1 ersetzen kann keines OneNote. Hier mal eine Auswahl von Produkten, die ich getestet habe:

Obsidian

Gut: Heißer Kandidat, den ich auch privat (unter anderem zum Schreiben der Blog-Einträge) nutze. Unzählige Erweiterungen, OpenSource, lässt sich mit eigenem Server, iCloud und anderen Diensten synchronisieren. Apps für Mac und iPad/iPhone. Mittlerweile haue ich alles an privaten Notizen dort hinein, aber das sind halt reine (getippte) Text-Notizen oder Links.

Was mir nicht gefällt: Sehr eingeschränkte Formatierungsoptionen (weil Markdown-basiert), Stylus kaum unterstützt (das Excalidraw-Plugin hat mich nicht überzeugt), das Management von Anhängen ist irgendwie konfus (alles landet in einem Sammelordner und man muss dann darauf verlinken, das Einbinden von Bildern, Dateien oder Audios funktioniert nicht so, wie ich es mir wünsche).

Bear

Gut: Übersichtliches Interface, Apps für alle notwendigen Plattformen, Sync möglich (aber nicht so vielseitig wie z. B. Obsidian).

Schlecht: Kostenpflichtig, Umgang mit Medien nicht so flexibel, keine Stylus-Unterstützung, beim Sync auch hier auf US-Anbieter angewiesen.

Notion

Gut: Kann alles, macht alles.

Schlecht: Kann zu viel, ich bin echt überfordert. Kostet einiges (in Pro-Version), Sync auf US-Server. Insgesamt für mich zu verwirrend und auch teuer.

Notebook

Ähnlich wie Bear, ein gutes, solides Notizbuch, aber auch hier Lock-in bei einem Anbieter und Sync auf US-Clouds, wenn ich mich richtig erinnere.

Apple Notes

Kann mehr, als man meint, aber dann am Ende doch nicht genug (und wird dann in meinen Augen auch unübersichtlich, wenn man mehrere hundert Notizen geordnet halten will). Außerdem nur Synchronisation über Apples Server, also USA.

Joplin

Schlecht: Handschrift lässt sich nicht so frei verwenden wie bei OneNote (getippter Text und Handschrift können „ineinander fließen“ und überlappen), die iPad-App ist ein wenig rudimentär (nur Markdown-Editor, kein Richt-Text), nicht perfekt um Inhalte zu präsentieren (z. B. muss ich manuelle Zeilenumbrüche einfügen, damit sich Text gut und in geeigneter Größe an die Tafel schmeißen lässt), der OneNote-Import klappt nicht gut, wenn fast jede der hunderten Notizen mit Handschrift vollgeschmiert ist – es wird nämlich jeder Strich als eigenes Bild importiert, sodass jede Notiz unfassbar anschwillt.

Gut: Import von OneNote ist grundsätzlich möglich, ich kann synchronisieren, wie ich will (bei mir: auf eine Nextcloud), Handschrift funktioniert noch recht gut (brauche ich aber tatsächlich immer weniger, da vieles über die ByCS Lernplattform läuft), Medien lassen sich nicht so wie in OneNote, aber dennoch gut nutzbar einbinden (und Audios direkt aus der iPad-App abspielen), das Programm ist OpenSource mit aktiver Community, dank Markdown lassen sich Inhalte aus Joplin inklusive kompletter Formatierung direkt in die Lernplattform der BayernCloud Schule (basierend auf moodle) rüberkopieren.

Am Ende bin ich bei Joplin gelandet und migriere jetzt – Stunde für Stunde – von OneNote, indem ich meine Unterrichtsnotizen und Materialien für den jeweils nächsten Tag Schritt für Schritt herüberkopiere und dabei entsprechend anpasse und überarbeite. Somit hänge ich zwar noch eine Zeit land an OneNote, aber ich brauche ja auch keine sofortigen, harten Schnitt.

Da die Daten verschlüsselt auf einem deutschen Server liegen, dürfte ich nun sogar personenbezogene Daten speichern, glaube ich, bislang ergab sich dafür aber noch keine Notwendigkeit.

Wer bis hierher gelesen hat: Respekt.

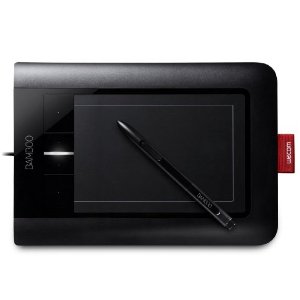

Ein Grafiktablett hat gegenüber der Maus den großen Vorteil, dass man den Cursor beim Retuschieren sehr viel genauer und intuitiver steuern kann. Bei der einfachen Anpassung von Tonwerten und Farben sowie beim Freistellen eines Bildes macht dies keinen großen Unterschied, fängt man aber mit Korrekturpinseln, Stempeln oder anderen „Freihandwerkzeugen“ wie Nachbelichter und Abwedler an, ist die Maussteuerung teilweise schon sehr nervig. Mit dem Grafiktablett sind solche Korrekturen (vom richtigen Zeichnen und Malen am PC ganz abgesehen) viel natürlicher möglich.

Ein Grafiktablett hat gegenüber der Maus den großen Vorteil, dass man den Cursor beim Retuschieren sehr viel genauer und intuitiver steuern kann. Bei der einfachen Anpassung von Tonwerten und Farben sowie beim Freistellen eines Bildes macht dies keinen großen Unterschied, fängt man aber mit Korrekturpinseln, Stempeln oder anderen „Freihandwerkzeugen“ wie Nachbelichter und Abwedler an, ist die Maussteuerung teilweise schon sehr nervig. Mit dem Grafiktablett sind solche Korrekturen (vom richtigen Zeichnen und Malen am PC ganz abgesehen) viel natürlicher möglich. Adobe Lightroom 3 ist der Nachfolger der von mir zur RAW-Konvertierung und ersten Bearbeitung verwendeten Software (Lightroom 2). In der Student & Teacher Edition ist das Programm sogar für relativ „wenig“ Geld (wenn man in den Dimensionen von Adobe-Produkten denkt) zu haben. Die relevantesten Verbesserungen gegenüber Lightroom 2 sind für meinen Geschmack die integrierte Objektivkorrektur, also das automatische Entzerren von Bildern sowie die deutlich verbesserte Rauschunterdrückung bei hohen ISO-Werten. Lightroom 2 geht beim Entrauschen relativ grob vor, wodurch viele Details verloren gehen. Lightroom 3 stellt hier einen enormen Entwicklungssprung dar: Bilder werden effektiver entrauscht, behalten aber dennoch selbst feine Details. Da ich regelmäßig mit hohen ISOs (z.B. 1600) fotografiere, wäre das eine enorme Hilfe.

Adobe Lightroom 3 ist der Nachfolger der von mir zur RAW-Konvertierung und ersten Bearbeitung verwendeten Software (Lightroom 2). In der Student & Teacher Edition ist das Programm sogar für relativ „wenig“ Geld (wenn man in den Dimensionen von Adobe-Produkten denkt) zu haben. Die relevantesten Verbesserungen gegenüber Lightroom 2 sind für meinen Geschmack die integrierte Objektivkorrektur, also das automatische Entzerren von Bildern sowie die deutlich verbesserte Rauschunterdrückung bei hohen ISO-Werten. Lightroom 2 geht beim Entrauschen relativ grob vor, wodurch viele Details verloren gehen. Lightroom 3 stellt hier einen enormen Entwicklungssprung dar: Bilder werden effektiver entrauscht, behalten aber dennoch selbst feine Details. Da ich regelmäßig mit hohen ISOs (z.B. 1600) fotografiere, wäre das eine enorme Hilfe. Warum einen neuen Fotorucksack? Weil er mehr Platz bietet! Mein derzeitiger Rucksack ist ziemlich voll, und wenn noch ein bisschen Zubehör dazukommt, läuft er förmlich über. Der Tamrac Expedition bietet einfach deutlich mehr Raum (insbesondere auch mehr kleine Fächer für Zubehör wie Ball-Bungees, Gel-Folien, Reinigungszubehör, Funkauslöser etc.) und ist – da er ein kein Sling-Rucksack ist – auch noch angenehmer zu tragen als mein Slingshot von Lowepro. Daneben bietet er hintendrauf auch noch die Möglichkeit, ein Stativ zu befestigen, so dass man dieses bei einer Fototour bequem transportieren kann. Leider sind die Dinger so unverschämt teuer, sonst hätte ich schon längst einen…

Warum einen neuen Fotorucksack? Weil er mehr Platz bietet! Mein derzeitiger Rucksack ist ziemlich voll, und wenn noch ein bisschen Zubehör dazukommt, läuft er förmlich über. Der Tamrac Expedition bietet einfach deutlich mehr Raum (insbesondere auch mehr kleine Fächer für Zubehör wie Ball-Bungees, Gel-Folien, Reinigungszubehör, Funkauslöser etc.) und ist – da er ein kein Sling-Rucksack ist – auch noch angenehmer zu tragen als mein Slingshot von Lowepro. Daneben bietet er hintendrauf auch noch die Möglichkeit, ein Stativ zu befestigen, so dass man dieses bei einer Fototour bequem transportieren kann. Leider sind die Dinger so unverschämt teuer, sonst hätte ich schon längst einen… Die Delamax EasyFolder ist eine 60x60cm große Softbox, welche speziell für Systemblitzgeräte (also z.B. die Canon Speedlites) gebaut wurde. Der Die Softbox wird also nicht, wie bei normalen Studiosoftboxen, direkt am Blitz festgeschraubt (geht ja auch nicht, da ein Speedlite kein Bajonett vorne dran hat), sondern auf einer speziellen Halterung befestigt. Der Blitz leuchtet dann von hinten durch ein kleines Loch in die Box rein. Dadurch bleibt auch der optische Empfänger des Blitzes draußen, so dass man das Speedlite auch im drahtlosen E-TTL-Betrieb nutzen kann, wenn man möchte. Durch einen Kugelkopf ist die Softbox frei schwenk- und drehbar. Warum nun aber eine Softbox? Einen Durchlichtschirm habe ich ja bereits. Dieser macht das Licht vom Blitz schön weich – aber er streut es auch in alle Richtungen. Eine wirklich exakte Lichtsetzung (also die Bestimmung, wo Licht und wo Schatten sein soll) ist damit nicht wirklich möglich. Die Softbox hingegen erzeugt auch ein wunderbar weiches Licht, hat aber durch die überstehenden Ränder ein viel schärfer begrenztes Ausleuchtungsfeld. So kann man z.B. bei einem Portrait relativ genau festlegen, welche Körperteile Licht abbekommen, und welche eher im Schatten „versinken“.

Die Delamax EasyFolder ist eine 60x60cm große Softbox, welche speziell für Systemblitzgeräte (also z.B. die Canon Speedlites) gebaut wurde. Der Die Softbox wird also nicht, wie bei normalen Studiosoftboxen, direkt am Blitz festgeschraubt (geht ja auch nicht, da ein Speedlite kein Bajonett vorne dran hat), sondern auf einer speziellen Halterung befestigt. Der Blitz leuchtet dann von hinten durch ein kleines Loch in die Box rein. Dadurch bleibt auch der optische Empfänger des Blitzes draußen, so dass man das Speedlite auch im drahtlosen E-TTL-Betrieb nutzen kann, wenn man möchte. Durch einen Kugelkopf ist die Softbox frei schwenk- und drehbar. Warum nun aber eine Softbox? Einen Durchlichtschirm habe ich ja bereits. Dieser macht das Licht vom Blitz schön weich – aber er streut es auch in alle Richtungen. Eine wirklich exakte Lichtsetzung (also die Bestimmung, wo Licht und wo Schatten sein soll) ist damit nicht wirklich möglich. Die Softbox hingegen erzeugt auch ein wunderbar weiches Licht, hat aber durch die überstehenden Ränder ein viel schärfer begrenztes Ausleuchtungsfeld. So kann man z.B. bei einem Portrait relativ genau festlegen, welche Körperteile Licht abbekommen, und welche eher im Schatten „versinken“. Ein einfaches Galgenstativ. Im Gegensatz zu einem normalen Lampenstativ ermöglicht der Galgen es dem Fotografen, die Lichtquelle (z.B. o.g. Softbox) direkt über bzw. schräg über der fotografierten Person zu positionieren. Dies erweitert die Möglichkeiten der Lichtsetzung enorm. Außerdem kann man durch den Galgen das Stativ weiter vom Modell weg aufstellen und rückt der fotografierten Person nicht ganz so nah „auf die Pelle“. Rückblickend muss ich sagen, dass ich besser von Anfang an nur Galgenstative gekauft hätte, denn außer für ein stur geradeaus leuchtendes Fülllicht hat ein normales Lampenstativ kaum Verwendung, bzw. ein Galgenstativ kann alles andere besser. Aber nuja, man lernt nie aus.

Ein einfaches Galgenstativ. Im Gegensatz zu einem normalen Lampenstativ ermöglicht der Galgen es dem Fotografen, die Lichtquelle (z.B. o.g. Softbox) direkt über bzw. schräg über der fotografierten Person zu positionieren. Dies erweitert die Möglichkeiten der Lichtsetzung enorm. Außerdem kann man durch den Galgen das Stativ weiter vom Modell weg aufstellen und rückt der fotografierten Person nicht ganz so nah „auf die Pelle“. Rückblickend muss ich sagen, dass ich besser von Anfang an nur Galgenstative gekauft hätte, denn außer für ein stur geradeaus leuchtendes Fülllicht hat ein normales Lampenstativ kaum Verwendung, bzw. ein Galgenstativ kann alles andere besser. Aber nuja, man lernt nie aus.

Das Canon EF 85/1.8 ist die Portraitlinse schlechthin, und vermutlich die Linse mit dem besten Preis-Leistungs-Verhältnis aller Canon-Objektive. Am Vollformat wird sie vor allem für Portraits ab der Hüfte verwendet, am Crop ist sie für Kopfportraits perfekt. Hat man etwas mehr Platz zur Verfügung, kann man sie natürlich auch an einer Crop-Kamera für Hüft- oder Ganzkörperportraits verwenden, daneben ist sie auf Grund ihrer riesigen Blendenöffnung und des schnellen USM-Autofokus auch für Hallensportarten wie z.B. Handball geeignet. Die Linse ist – vor allem wenn man den relativ günstigen Preis berücksichtigt – von der Abbildungsleistung her der Hammer. Sie liefert gestochen scharfe Bilder und ist perfekt, um Personen bzw. deren Gesichter freizustellen und den Hintergrund in einer schönen Unschärfe verschwinden zu lassen. Da sie meinen derzeitigen Objektivpark (wenn man bei drei Objektiven davon sprechen kann) da um sehr viel Lichtstärke erweitern würde, wo ich noch nichts lichtstarkes habe – im leichten Telebereich – steht sie momentan unangefochten auf Platz 1 der von mir gewünschten Objektive. Leider ist das Ding so gut, dass es 1) fast niemand verkauft und 2) der Gebrauchtpreis fast genauso hoch ist wie der Neupreis.

Das Canon EF 85/1.8 ist die Portraitlinse schlechthin, und vermutlich die Linse mit dem besten Preis-Leistungs-Verhältnis aller Canon-Objektive. Am Vollformat wird sie vor allem für Portraits ab der Hüfte verwendet, am Crop ist sie für Kopfportraits perfekt. Hat man etwas mehr Platz zur Verfügung, kann man sie natürlich auch an einer Crop-Kamera für Hüft- oder Ganzkörperportraits verwenden, daneben ist sie auf Grund ihrer riesigen Blendenöffnung und des schnellen USM-Autofokus auch für Hallensportarten wie z.B. Handball geeignet. Die Linse ist – vor allem wenn man den relativ günstigen Preis berücksichtigt – von der Abbildungsleistung her der Hammer. Sie liefert gestochen scharfe Bilder und ist perfekt, um Personen bzw. deren Gesichter freizustellen und den Hintergrund in einer schönen Unschärfe verschwinden zu lassen. Da sie meinen derzeitigen Objektivpark (wenn man bei drei Objektiven davon sprechen kann) da um sehr viel Lichtstärke erweitern würde, wo ich noch nichts lichtstarkes habe – im leichten Telebereich – steht sie momentan unangefochten auf Platz 1 der von mir gewünschten Objektive. Leider ist das Ding so gut, dass es 1) fast niemand verkauft und 2) der Gebrauchtpreis fast genauso hoch ist wie der Neupreis.